寻找IO杀手进程

linux下可以通过iostat查看目前主机总的io使用情况,不过当通过top等命令查看时,发现cpu wait占多过多,想定位具体是哪些程序占用了IO,本篇就通过一些常用的手段进行汇总下。

一、top下的wait状状

wa = I/O waiting ,wa指的是CPU等待磁盘写入完成的时间,就是说前提是要进行IO操作,在进行IO操作的时候,CPU等待时间。如一个程序执行的最后,从系统空间到dst硬盘空间的时候,如果程序是阻塞的,那么这个时候cpu就要等待数据写入磁盘才能完成写操作了。所以这个时候cpu等待的时间就是wa。

所以wa状态占比越高,证明IO越繁忙。我们可以通过以下指令查看当前io的总终态:

1[root@361way ~]# sar -u 2 5

2Linux 2.6.32-431.29.2.el6.x86_64 (361way) 01/25/2015 _x86_64_ (1 CPU)

306:59:58 PM CPU %user %nice %system %iowait %steal %idle

407:00:00 PM all 1.00 0.00 0.50 0.00 0.00 98.50

507:00:02 PM all 5.05 0.00 1.52 1.01 0.00 92.42

607:00:04 PM all 0.50 0.00 0.50 0.00 0.00 98.99

707:00:06 PM all 0.00 0.00 0.00 0.00 0.00 100.00

807:00:08 PM all 0.50 0.00 0.00 0.50 0.00 98.99

9Average: all 1.41 0.00 0.50 0.30 0.00 97.79

10[root@361way ~]# vmstat 2 5

11procs -----------memory---------- ---swap-- -----io---- --system-- -----cpu-----

12 r b swpd free buff cache si so bi bo in cs us sy id wa st

13 0 0 0 98488 209916 218256 0 0 8 28 11 10 5 0 95 0 0

14 0 0 0 98480 209916 218256 0 0 0 0 155 198 0 0 100 0 0

15 0 0 0 98496 209916 218256 0 0 0 0 141 191 1 0 99 0 0

16 0 0 0 98496 209916 218256 0 0 0 0 142 189 0 1 99 0 0

17 0 0 0 98512 209916 218256 0 0 0 0 152 189 0 0 100 0 0

18[root@361way ~]# iostat -x 1 2

19Linux 2.6.32-431.29.2.el6.x86_64 (361way) 01/25/2015 _x86_64_ (1 CPU)

20avg-cpu: %user %nice %system %iowait %steal %idle

21 4.71 0.00 0.42 0.24 0.00 94.63

22Device: rrqm/s wrqm/s r/s w/s rsec/s wsec/s avgrq-sz avgqu-sz await svctm %util

23xvda 0.00 0.13 0.31 0.91 14.08 8.30 18.39 0.01 11.84 1.38 0.17

24xvdb 0.00 2.12 0.05 3.90 1.52 48.10 12.57 0.05 11.84 0.57 0.22

25avg-cpu: %user %nice %system %iowait %steal %idle

26 0.00 0.00 0.00 0.00 0.00 100.00

27Device: rrqm/s wrqm/s r/s w/s rsec/s wsec/s avgrq-sz avgqu-sz await svctm %util

28xvda 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

29xvdb 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

二、找出IO繁忙的进程

可以通过linux下最常用的两个命令top、ps找出目前正在占用IO的进程。在进行下一步之前我了解一下D状态,ps命令中查看的状态有D、R、S、Z、T ,D状态指不可中断睡眠 (通常是在IO操作) 收到信号不唤醒和不可运行, 进程必须等待直到有中断发生。

找出当前进程为D的状态:

1while true; do date; ps auxf | awk '{if($8=="D") print $0;}'; sleep 1; done

上面的这个操作有一个缺点,就是一旦匹配到一个进程为D的,就开始重新执行下一个循环。而想查看所有当于D状态的进程,可以将其改为如下:

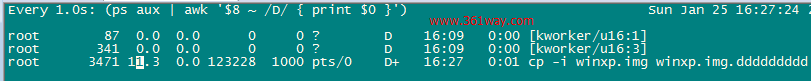

1watch -d -n 1 "(ps aux | awk '\$8 ~ /D/ { print \$0 }')"

如下,是我在执行一个大文件的cp时,通过上面的指令查看到的结果:

除此之外,还可以通过专用工具去查看,如iotop或latencytop。这里以iotop为例,执行后会显示当前的读写速度及每个进程占用的速度。执行后可以按o仅显示占用IO的进程:

1[root@361way ~]# iotop --help

2Usage: /usr/sbin/iotop [OPTIONS]

3DISK READ and DISK WRITE are the block I/O bandwidth used during the sampling

4period. SWAPIN and IO are the percentages of time the thread spent respectively

5while swapping in and waiting on I/O more generally. PRIO is the I/O priority at

6which the thread is running (set using the ionice command).

7Controls: left and right arrows to change the sorting column, r to invert the

8sorting order, o to toggle the --only option, p to toggle the --processes

9option, a to toggle the --accumulated option, q to quit, any other key to force

10a refresh.

11Options:

12 --version show program's version number and exit

13 -h, --help show this help message and exit

14 -o, --only only show processes or threads actually doing I/O

15 -b, --batch non-interactive mode

16 -n NUM, --iter=NUM number of iterations before ending [infinite]

17 -d SEC, --delay=SEC delay between iterations [1 second]

18 -p PID, --pid=PID processes/threads to monitor [all]

19 -u USER, --user=USER users to monitor [all]

20 -P, --processes only show processes, not all threads

21 -a, --accumulated show accumulated I/O instead of bandwidth

22 -k, --kilobytes use kilobytes instead of a human friendly unit

23 -t, --time add a timestamp on each line (implies --batch)

24 -q, --quiet suppress some lines of header (implies --batch)

捐赠本站(Donate)

如您感觉文章有用,可扫码捐赠本站!(If the article useful, you can scan the QR code to donate))

如您感觉文章有用,可扫码捐赠本站!(If the article useful, you can scan the QR code to donate))

- Author: shisekong

- Link: https://blog.361way.com/find-linux-iowait/4073.html

- License: This work is under a 知识共享署名-非商业性使用-禁止演绎 4.0 国际许可协议. Kindly fulfill the requirements of the aforementioned License when adapting or creating a derivative of this work.